Van experiment tot eigen AI‑infrastructuur.

Als early adopters van Artificial Intelligence waren wij er vroeg bij. In 2023 begonnen we met het integreren van de OpenAI‑API binnen onze webomgevingen, software en mobiele apps, waarmee we de eerste AI‑prototypes en modules ontwikkelden op het gebied van tekst‑LLM's en automatisering.

Wat begon als een reeks experimenten groeide uit tot een diepe expertise in het ontwerpen en implementeren van volledig eigen AI‑architecturen die slimmer, sneller en flexibeler werken dan traditionele digitale oplossingen.

In 2025 bouwden we een eigen lokale AI‑omgeving — een krachtige infrastructuur die zowel draait op RTX‑GPU's als in de cloud. Zo combineren wij lokale rekenkracht met schaalbare infrastructuur.

We ontwikkelen met open‑source LLM's (voor tekst, beeld, audio en video) en bouwen hierop eigen AI‑engines, nodes en orchestratie‑lagen in Python. Door deze combinatie creëren we praktische, veilige en schaalbare AI‑oplossingen die direct in te passen zijn binnen bestaande bedrijfsprocessen.

Onze Kennis

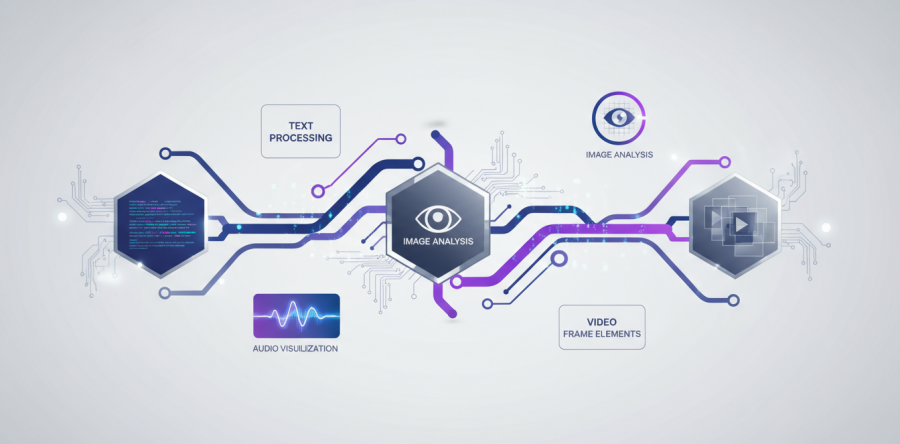

Modulaire AI-architectuur

Wij bouwen engine-based stacks met specifieke nodes voor tekst, beeld, audio en video – geschikt voor web, software en mobiele toepassingen.

Multimodale integratie

Eén geïntegreerde workflow waarin taal, beeld, geluid, 3D-data en video samenwerken binnen uw bestaande processen.

Custom LLM-ontwikkeling

Van slimme chat-assistenten tot interne kennisagents die draaien op uw eigen, afgeschermde data.

LoRA

RAG

AI-media en content-technologie

Toepassingen voor beeld-, video- en audioproductie, tagging, transcriptie en creatieve AI-content.

Toegepast in Playanote.nl

Lokale & veilige verwerking

Onze AI-stacks draaien zowel lokaal (on-premise) als in de cloud.

AVG-compliant

On-premise